3.门控循环单元 GRU

3. 门控循环单元(Gated Recurrent Unit, GRU)

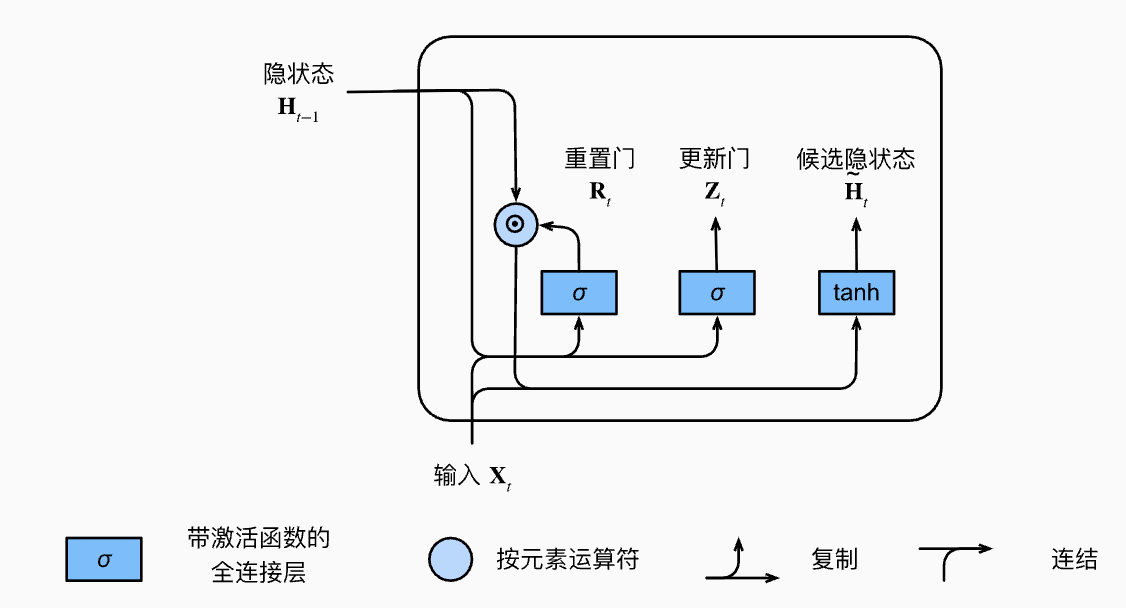

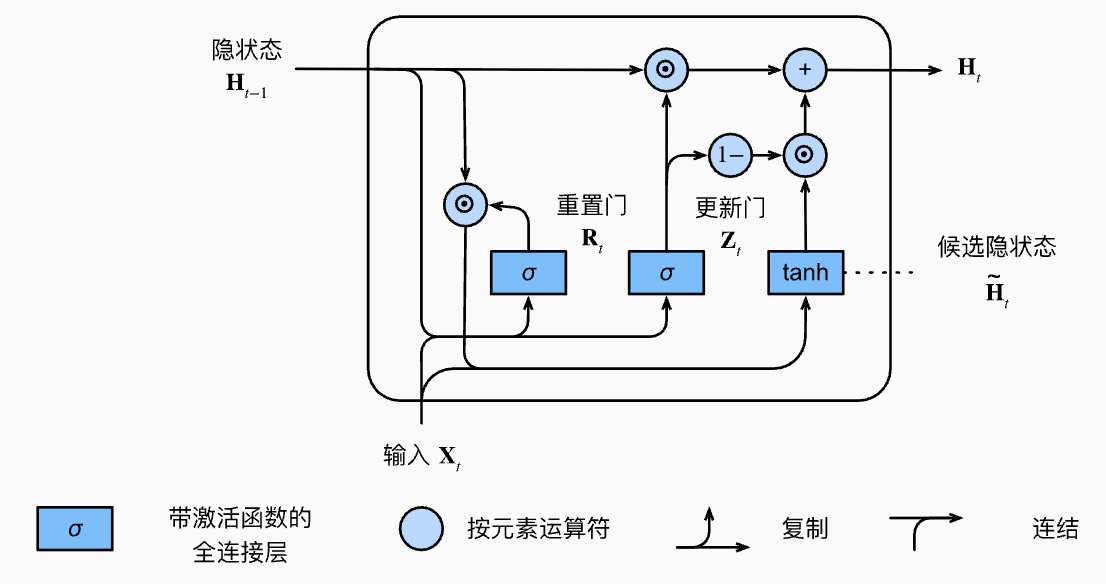

- 核心思想:GRU 能动态决定当前时刻要"记住"多少过去的信息、要"遗忘"多少无用内容,从而有效缓解传统RNN的长期依赖问题。它通过"更新门"和"重置门"两个机制,灵活调整信息流。

1. 信息处理机制

- 不是每个历史信息都同等重要,GRU能自动筛选:

- 更新门(Update Gate)

:决定当前隐状态 有多少来自之前的 ,有多少来自新的候选状态 。 - 重置门(Reset Gate)

:控制在生成候选隐状态 时,允许历史状态 保留多少参与计算——即决定遗忘多少过去信息。

- 更新门(Update Gate)

2. 计算流程

-

门的计算

- Reset gate:

- Update gate:

- Reset gate:

-

候选隐状态(Candidate hidden state):

控制 的遗忘程度 :元素相乘(Element-wise Multiplication) 表示历史信息"筛选"后参与计算。 激活将输出限制在 。

-

隐状态(Hidden state):

:控制 保留多少旧信息 :控制引入多少新信息

3. 总结

- Reset Gate(重置门):决定历史信息参与新状态生成的多少,有助于捕获短期依赖。

- Update Gate(更新门):决定当前状态更多依赖过去还是新信息,有助于长期依赖建模。

- 公式汇总:

- 通俗理解:GRU 就像"信息筛选器",每个时间步自动判断保留多少旧知识、吸收多少新知识,让神经网络更聪明地理解和处理序列信息。

参考资料

“觉得不错的话,给点打赏吧 ୧(๑•̀⌄•́๑)૭”

微信支付

支付宝支付

3.门控循环单元 GRU

http://neurowave.tech/2025/04/17/5-3-RNN-GRU/