4.长短期记忆网络 LSTM

4. 长短期记忆网络(Long short-term memory, LSTM)

- 核心思想:LSTM 通过引入"门控"机制,能够选择性地记住有用信息、忘记无用信息,有效缓解RNN在处理长序列时的"梯度消失"和"长期依赖"问题。

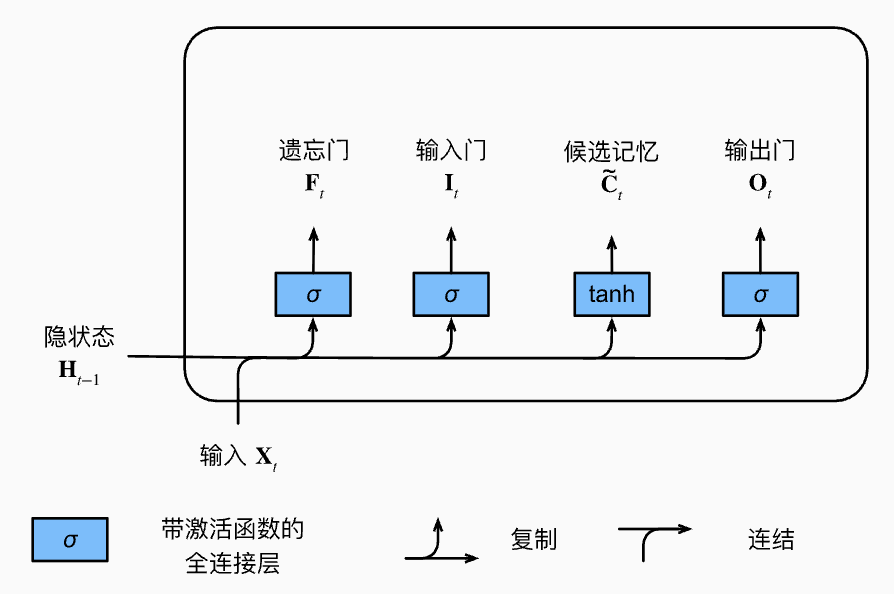

1. 门结构与功能

- 忘记门(Forget Gate)

:决定前一时刻记忆 有多少被保留到当前时刻, 取0则完全遗忘,取1则全部保留。 - 输入门(Input Gate)

:决定当前时刻新信息(候选记忆单元 )有多少被写入记忆单元。 - 输出门(Output Gate)

:决定当前细胞状态 有多少信息被输出到最终隐状态 。

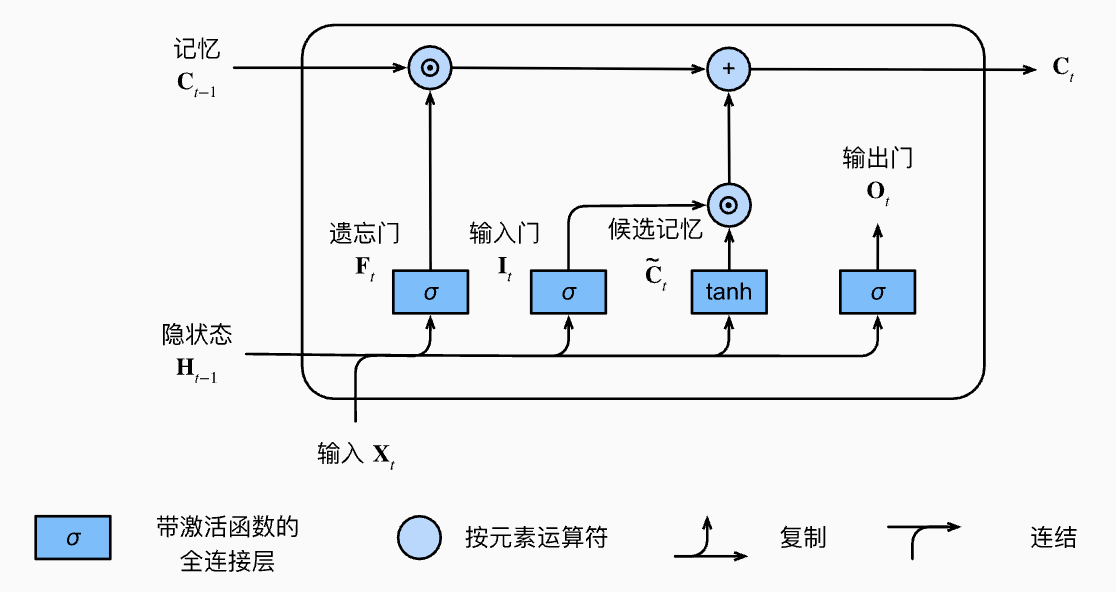

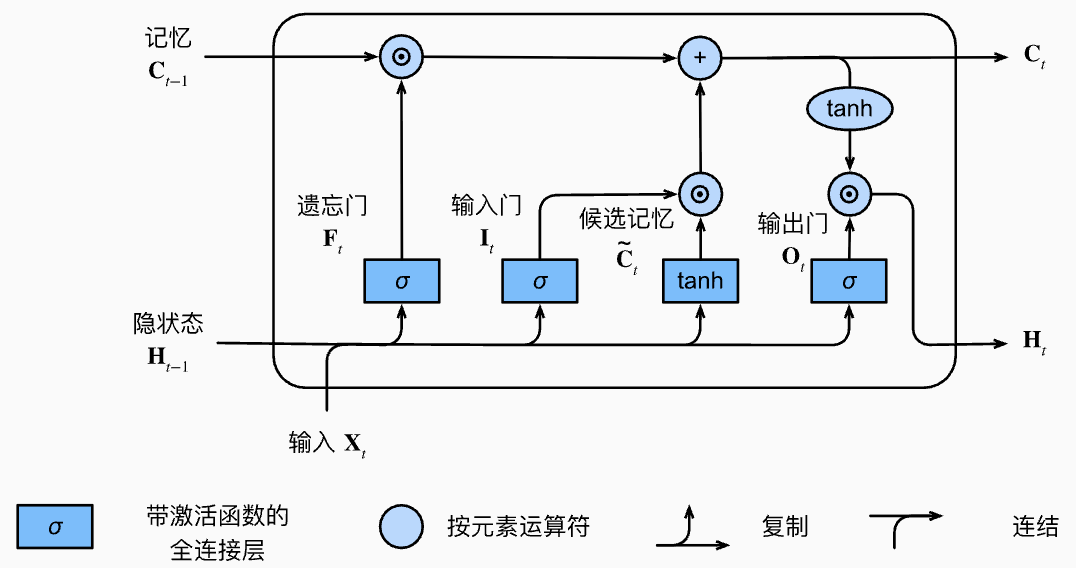

2. 计算流程

-

门的计算

是sigmoid激活,输出范围 。

-

候选记忆单元(candidate memory cell)

输出范围 。

-

记忆单元(Memory Cell)更新

控制遗忘多少旧信息, 控制写入多少新信息。 表示元素乘。

-

隐状态(Hidden State)输出

控制 有多少被输出。

3. 总结

- Forget Gate 决定遗忘/保留旧记忆,Input Gate 控制新信息写入,Output Gate 控制输出多少记忆作为当前隐状态。

- LSTM 能有效捕获长距离依赖,解决RNN难以处理的序列建模问题。

- 广泛应用于语言建模、机器翻译、序列标注等任务。

- 公式

- 通俗理解:LSTM 就像一个"智能记事本",能随时决定擦掉哪些旧内容、记下哪些新内容、对外展示哪些重点,让信息流动更有条理。

参考资料

“觉得不错的话,给点打赏吧 ୧(๑•̀⌄•́๑)૭”

微信支付

支付宝支付

4.长短期记忆网络 LSTM

http://neurowave.tech/2025/04/17/5-4-RNN-LSTM/